近期,国内互联网公司在打响“百模大战”的同时,也在不妨碍原有业务的前提下,尽可能腾挪手中算力资源,以满足大模型训练刚需。

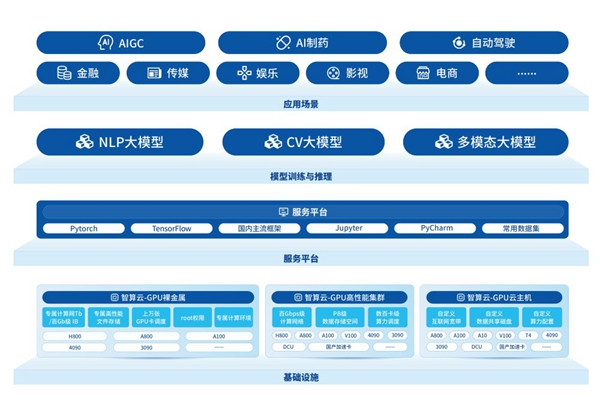

为缓解GPU卡资源紧张问题,并行科技将在2023年底前,以“算力网络”为依托,为大模型行业带来GPU资源“及时雨”,上线超万P超算架构大模型算力。然而,对AI大模型训练来说,解决GPU卡的资源问题只是第一步。面对训练时的大规模计算需求,并行科技还提供强有力的技术支撑,以解决机间网络性能的问题。

大模型算力不是云计算!是超算!

在进行大模型训练时,需要大量GPU资源组成算力集群来应对极高的密集性计算,换句话说,考验的是规模性算力资源在短时间内的计算“爆发力”,对算力、算法、数据三方面的技术均有一定要求,再强的单卡也只是整体运算过程中的节点,单打独斗无法完成AI大模型的算力任务。所以,有别于分布式的云计算技术,需要专用的高速互联计算网络、高性能文件存储和强劲的GPU算力,其本质是基于高性能计算架构的超算算力。

并行智算云是并行科技针对人工智能和高性能计算场景的算力服务平台,面向企事业单位、高校、科研院所在人工智能领域和高性能计算等方向的GPU算力需求,提供专业、海量的GPU算力云。通过云主机、高性能集群和裸金属三大产品体系支撑,基于高性能计算环境构建GPU算力服务平台,以满足大规模预训练、微调、高并发推理和高精度科学计算中对计算、存储、网络等环节的多样性需求。

但满足硬件和技术的客观需求,并不意味着接下来训练AI大模型的工作就会顺理成章,因为若想让大模型顺畅地运行,并最终得到理想成果,后续的服务保障体系同样重要。

大模型算力可用、好用、降本

行业发展风口下的时间如同“生命线”。对大模型训练而言,只有在当前备受各界关注的行业黄金期“提前交卷”的参与者,才有可能获得更多资源与空间。

但大模型训练不仅需要充沛的资源与完善的技术体系,后续的保障服务同样至关重要。并行科技始终坚持技术、服务两手抓的发展思路,不止为用户提供单一技术、单一资源,而是一套满足用户综合发展需求的行业解决方案。

并行科技专家团队的7×24小时在线服务就是为大模型训练保驾护航的有效方式,针对模型框架的安装、部署、优化以及长时间运行的保障诉求等提供在线技术支持,让终端用户轻松调度算力资源。近日,AI领域知名企业重点项目经过并行科技应用服务团队的调优,使单个512卡大模型训练任务性能提升了约40%,实现算力从“可用”向“好用”转化的同时,成本投入大幅降低。

强势助力用户研究成果落地

作为超算架构大模型算力网络先行者,并行科技已与智谱AI、智源研究院等大模型领域头部公司达成合作。

智谱AI与并行科技合作的初衷,一方面是借助AI技术与高性能计算GPU算力平台的合力,加速大模型的训练、微调与推理,推进大模型及其应用的快速迭代升级。另一方面,借助云服务模式,极大降低大模型使用门槛,进而实现大模型的普惠化和实用化。

在与智源研究院的合作中,并行科技算力网络提供数百张A100卡,支撑智源大模型研发,助力人工智能大模型创新发展。

在AI大模型发展的关键阶段,资源、技术、服务、客户,都是选择一家优质算力服务商的关键因素。并行科技将以超算架构大模型算力网络先行者的角色,与行业伙伴共同探索通用人工智能发展路径,集聚创新资源,优化产业生态,使大模型算力资源可用、好用、降本。(科文)